نظام حاکم بر جهان باید هرچه زودتر به ایجاد یک قرارداد اجتماعی جدید کمک کند تا اطمینان یابد که فناوریهای جدید، و به ویژه هوش مصنوعی، به شکلی ایمن و هماهنگ با نیازهای اخلاقی دنیایی که به سمت جهانیسازی به پیش میرود، به کار میرود.

اینروزها، خیلی از باتهای مخرب انترنتی، صفحات فیسبوکی وبسایتهای خبری جعلی انترنت را تسخیر کردهاند که پیامدهای قابل توجهی در سطح جهان داشته است. فقط چند رویداد اخیر را در نظر بگیرید: در انتخابات ریاست جمهوری سال ۲۰۱۶ امریکا، روسیه با استفاده از یک کارزار انتخاباتی گسترده، شامل تبلیغات پولی، حسابهای رسانهای جعلی و محتواهای متضاد و اختلافبرانگیز بود، به حمایت از یکی از کاندیداها پرداخت و او را در برابر رقیبش تقویت کرد.

در چین، شرکتهای بزرگ فناوریای چون علیبابا و تنسنت میلیونها دوربین تشخیص چهره را بهکار گرفتهاند تا جریان مداوم دادههای خصوصی شهروندان را کنترل کنند. در میانمار، یک گزارش سازمان ملل متحد تایید کرده که پستهای فیسبوکی سازماندهیشده بر ضد مسلمانان روهینگیا موجب افزایش نفرت هتک حرمت آنها شده است.

اتحاد قدرتمند و پرمنفعت میان هوش مصنوعی و جامعهٔ اطلاعاتمحور، شبکههای اجتماعی را به معماران تعاملات ما تبدیل کرده؛ این شبکهها در حال شکلدهی واقعیت به نحو دلخواه خود هستند.

در این وضعیت، نگرانیهایی جدی در خصوص از کنترل خارج شدن انقلاب الگوریتمی مطرح شده است. انقلابی که ظاهرا برای بسیاری نه قابل درک است و نه قابل پیشبینی. و همزمان اعتماد به دولتها و سازمانهای جهانی برای مهار این وضعیت به شدت مخدوش شده است.

در حال حاضر، به نظر میرسد فناوری هوش مصنوعی به جای تقویت راهکارهای کنترلی در جهان، به تضعیف آن بیشتر تمایل دارند. سازمان ملل متحد در این زمینه با دشواریهای عظیم و در همتنیدهای روبروست که در اینجا سه چالش آن را بررسی میکنیم.

هوش مصنوعی و قُلب واقعیت

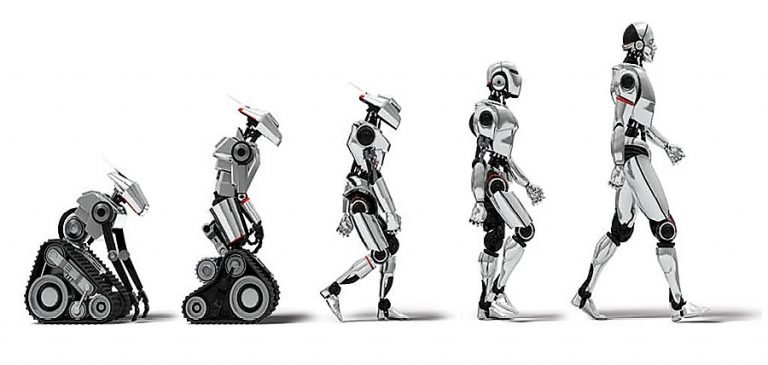

هوش مصنوعی بهطور ذاتی یک فناوری دوکاربردی است که پیشبینی و مهار پیامدهای چشمگیر آن (منفی مثبت) به شدت دشوار است.

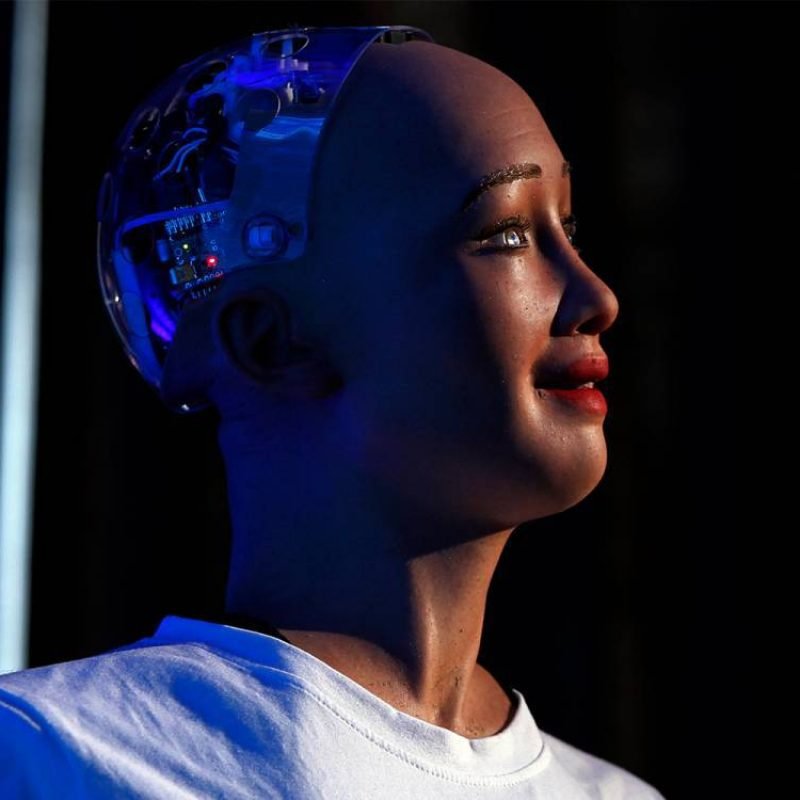

مثلا در حالا حاضر، برنامههای پیچیدهٔ هوش مصنوعی – موسوم به دیپفیک (Deepfake) – میتواند صداها، تصاویر و ویدیوها را با هدف جعل هویت طوری دستکاری کند که تفکیک آن اغلب از نسخهٔ اصلی ناممکن است. هوش مصنوعی با تکیه بر الگوریتمهای موسوم به یادگیری عمیق یا Deep Learning، با دقتی حیرتآور میتواند لبخوانی کند و سخن بگوید و تا حدی حالات چهره انسان را هنگام ادای واژهها شبیهسازی کند.

چنین فناوریهایی در بیرون از آزمایشگاه به راحتی میتواند مورد سوءاستفاده قرار گیرد که تبعاتی گسترده به همراه خواهند داشت. (در واقع، همین حالا چنین سوءاستفادههایی در سطح پایینی صورت میگیرد.) در جریان انتخابات ویدیوهای جعلی دیپفک میتوانند مقامات دولتی را در به عنوان افرادی پولشویی مرتبطند، نشان دهد؛ هشدارهای تقلبی ویدیویی در مورد اپیدمیها یا حملات سایبری، میتواند به افزایش هراس عمومی منجر شود و یا از این فناوری به منظور افزایش تنشهای بینالمللی استفاده شود.

تاثیرگذاری بر افکار عمومی با شبیهسازیهای گمراهکننده میتواند بر نقش سازمان ملل در تأمین صلح و امنیت جهانی اثرات درازمدت و قویای به جا بگذارد. اخبار جعلی، با از بین بردن تدریجی حس اعتماد میان شهروندان و دولت – و حتی میان دولتها – میتواند برای به نظام قانونی حاکم بر جهان صدمه وارد کند.

هوش مصنوعی و نظارت دقیق

هوش مصنوعی در حال حاضر با انواع فناوریهای دیگر، از جمله بیوتکنولوژی، که نقش مهمی در امنیت جهانی دارد، سازگار و مرتبط است. سیستمهای هوش مصنوعی در سراسر جهان برای پیشبینی جنبههای مختلف زندگی روزمرهٔ ما، با تجزیه و تحلیل و معنابخشی به مجموعههای اطلاعات و دادههای عظیمی مثل الگوهای ترافیک شهرها، بازارهای مالی، روند دادههای رفتار مصرفکننده، پروندههای بهداشتی و حتی ژنومهای ما، توسعه داده شدهاند.

این قابلیتهای هوش مصنوعی بهطور فزایندهای میتواند دادههای رفتاری و بیولوژیکی ما را به اشکالی نوآورانه و اغلب دستکاریشده، تحت کنترل درآورند که پیامدهایی برای همهٔ ما خواهد داشت. به عنوان نمونه، عروسک هوشمند «دوست من، کایلا» دادهها و اطلاعات صدا و هیجانات کودکانی را که با آن بازی میکنند، به سرور تولیدکننده خود میفرستد. همین امر منجر به شکایت کمیسیون تجارت فدرال آمریکا از تولیدکننده و ممنوعیت این عروسک در آلمان شده است. در حال حاضر در دادگاههای ایالات متحده از تجزیه و تحلیلهای تصاویر ویدیویی برای تشخیص حس ندامت و پشیمانی استفاده میشود و امکان دارد بهزودی از همین شیوه برای مصاحبههای شغلی و ارزیابی پاسخهای کاندیداها و شایستگیشان برای شغل مورد نظر، استفاده شود.

توانایی هوش مصنوعی در زمینهٔ نفوذ بالقوهٔ بر رفتار افراد تاثیرات مستقیمی بر برنامهٔ حقوق بشر سازمان ملل دارد. اشکال جدید کنترل اجتماعی و بیولوژیکی میتواند در واقع، نیازمند تجدید نظر در چارچوب کنونی برای نظارت بر اجرای اعلامیه جهانی حقوق بشر باشد، و قطعا مستلزم این خواهد بود که نظام جهانی پیشبینی بهتر و درکی از پیچیدگیهای فزاینده مرتبط با هوش مصنوعی داشته باشد.

هوش مصنوعی در میدان نبرد

و سرانجام این که، توانایی فناوریهای هوش مصنوعی برای اثرگذاری بر جمعیتهای بزرگ از چنان ارزش فوری و برجستهای برخوردار است که تقریبا با اطمینان کامل میشود گفت که هوش مصنوعی عرصهٔ نبردهای آینده خواهد بود. در این زمینه، احتمال وقوع جدی یک «مسابقه سایبری» وجود دارد؛ مسابقهای که در آن کشورهای قدرتمند با تکنولوژی هوش مصنوعی برای جمعآوری اطلاعات، به عنوان سوخت دستیابی به برتری اقتصادی، پزشکی و امنیتی در سراسر جهان، وارد رقابتی آشکار شوند. از سوی دیگر، در حالیکه دولتهای قدرتمند به شکلی روزافزون به تواناییهای بیشتری در خصوص هوش مصنوعی و فناوری بیولوژیکی برای فهم و کنترل بالقوهٔ جمعیت و اکوسیستم دیگر کشورها دست مییابند، احتمال شکلگیری اَشکالی از «استعمار سایبری» نیز افزایش مییابد.

به سوی حاکمیت جهانی هوش مصنوعی

از نظر سیاسی، قانونی و اخلاقی، جوامع ما برای استقرار و بهکارگیری گستردهٔ هوش مصنوعی آماده نیستند. و سازمان ملل متحد، که دههها قبل از ظهور فناوریهای تاسیس شده، از بسیاری جهات برای ایجاد نظام جهانی مسئولی که توانایی و ظرفیت ممانعت از سوءاستفاده از هوش مصنوعی را داشته باشد، ناکارآمد است.

در واقع، بازگشت ناسیونالیسم در برخی از کشورهای جهان میتواند از کاهش تدریجی ظرفیت نظام جهانی با نقشی معنادار در کنترل هوش مصنوعی، حاکی باشد. این احتمال وجود دارد که در آینده شرکتهای بزرگ و کشورهای قدرتمند به رویکردهای چندملیتی ارزشی چندانی قائل نشوند، چرا که هوش مصنوعی سودآور است و بسیاری ترجیح میدهد در مالکیت خصوصی باقی بماند.

با همهٔ اینها، برخی راهکارهای بدیع وجود دارد که سازمان ملل متحد میتواند با استفاده از آن شبکههای مشارکتی و شفافی ایجاد کند تا به رفع بیاعتمادی نسبت به ظرفیت این سازمان کمک شود.

مرکز تحقیقات سیاستگذاری در دانشگاه سازمان ملل متحد، به دلیل ماموریتی که در پیادهسازی استراتژی دبیرکل این سازمان در خصوص فناوریهای جدید دارد، مرکزی به نام «هوش مصنوعی و نظام دولتداری جهانی» را به عنوان فضایی برای تعامل و همفکری پژوهشگران، بازیگران سیاسی، شرکتها و رهبران ایجاد کرده تا چالشهای سیاسی را که هوش مصنوعی در جهان به وجود آورد، بررسی کند.

هدف از ایجاد این مرکز دستیابی به بینش و آگاهی ویژه و تبادل نظرات و تجارب کشورها در خصوص هوش مصنوعی است. دانشی که این مرکز از این طریق کسب میکند میتواند برای حمایت از کشورهای عضو سازمان ملل، نهادهای چندملیتی و دیگر ذینفعان استفاده شود.

احتمالا مهمترین چالش سازمان ملل در این راستا بازگرداندن اعتماد عمومی به کارآمدی یک نظام جهانی در کنترل هوش مصنوعی خواهد بود. اما قرائن حاکی از آن است که فناوری هوش مصنوعی برای هر فرد و هر دولت یک مسئله است و اینکه بدون شکلی از حاکمیت جمعی و همکارانه، این احتمال به شکلی واقعی وجود دارد که هوش مصنوعی ثبات جهان را به مخاطره خواهد انداخت.

ـــــــــــــــــــــــــــــــــــــ

منبع (تلخیص و ترجمه آزاد): مجله مجمع اقتصادی جهان